이 포스트는 한빛미디어에서 출간한 '트랜스포머를 활용한 자연어 처리'을 읽고 작성한 서평입니다.

INTRO

자연어 처리(NLP) 관련 업무를 하시는 분들에게는 버트(BERT)와 트랜스포머(Transformer)는 새로운 세대의 출현이라고 할만큼 중요하고 필수적인 지식이 되었습니다. 특히, 최근 트랜스포머(Transformer)에서 파생되는 다양한 모델들은 문서 요약, 생성, 분류 등 다양한 곳에 활용되고 있는데, 이러한 모델들을 손쉽게 활용할 수 있도록 활용성을 높여주는 집단이 바로 이 책의 저자들이 속한 허깅페이스(Hugging Face) 입니다.

책 소개

트랜스포머는 우리 주변에 가득하다! 트랜스포머 아키텍처는 순식간에 자연어 처리 분야를 지배했다. 기자처럼 뉴스를 작성하고, 프로그래머의 코드를 자동 완성하며, 사람들이 원하는 그림을 그려내고 있다. 이 책은 데이터 과학자나 프로그래머가 트랜스포머 모델을 훈련하고 확장할 수 있도록 허깅페이스의 트랜스포머스 라이브러리를 활용하는 실용적인 방법을 안내한다. 허깅페이스에서 트랜스포머스 라이브러리를 개발한 엔지니어들이 직접 예제 코드를 설명하며 트랜스포머의 작동 원리와 이를 사용한 문제 해결법, 실제 애플리케이션 도입법까지 차근차근 소개한다. 나만의 트랜스포머를 훈련시키는 방법을 배우고 자연어 처리를 정복해보자.

이 책의 구성

- 트랜스포머를 입맛에 맞게 조정하고 싶은 데이터 과학자와 머신러닝 엔지니어

- 자기만의 자연어 처리 애플리케이션을 만들고 싶은 개발자

주요 내용

- 텍스트 분류, 개체명 인식 등 NLP 작업을 위한 트랜스포머 모델을 빌드 및 디버깅, 최적화하는 방법

- 언어 간 전이 학습에 트랜스포머를 사용하는 방법

- 레이블링된 데이터가 부족한 상황에서 트랜스포머를 적용해 모델 성능을 높이는 방법

- 지식 정제와 양자화, 가지치기 같은 기술을 사용한 트랜스포머 모델 효율화 방법

- 대규모 트랜스포머 모델을 밑바닥부터 훈련하고 여러 GPU 및 분산 환경으로 확장하는 방법

목차

CH1. 트랜스포머 소개

- 인코더-디코더 프레임워크

- 어텐션 메커니즘

- NLP의 전이 학습

- 허깅페이스 트랜스포머스

- 트랜스포머 애플리케이션 둘러보기

- 허깅페이스 생태계

- 트랜스포머의 주요 도전 과제

- 결론

CH2. 텍스트 분류

- 데이터셋

- 텍스트에서 토큰으로

- 텍스트 분류 모델 훈련하기

- 결론

CH3. 트랜스포머 파헤치기

- 트랜스포머 아키텍처

- 인코더

- 디코더

- 트랜스포머 유니버스

- 결론

CH4. 다중 언어 개체명 인식

- 데이터셋

- 다중 언어 트랜스포머

- XLM-R 토큰화

- 개체명 인식을 위한 트랜스포머

- 트랜스포머 모델 클래스

- NER 작업을 위해 텍스트 토큰화하기

- 성능 측정

- XLM-RoBERTa 미세 튜닝하기

- 오류 분석

- 교차 언어 전이

- 모델 위젯 사용하기

- 결론

CH5. 텍스트 생성

- 일관성 있는 텍스트 생성의 어려움

- 그리디 서치 디코딩

- 빔 서치 디코딩

- 샘플링 방법

- 탑-k 및 뉴클리어스 샘플링

- 어떤 디코딩 방법이 최선일까요?

- 결론

CH6. 요약

- CNN/DailyMail 데이터셋

- 텍스트 요약 파이프라인

- 요약 결과 비교하기

- 생성된 텍스트 품질 평가하기

- CNN/DailyMail 데이터셋에서 PEGASUS 평가하기

- 요약 모델 훈련하기

- 결론

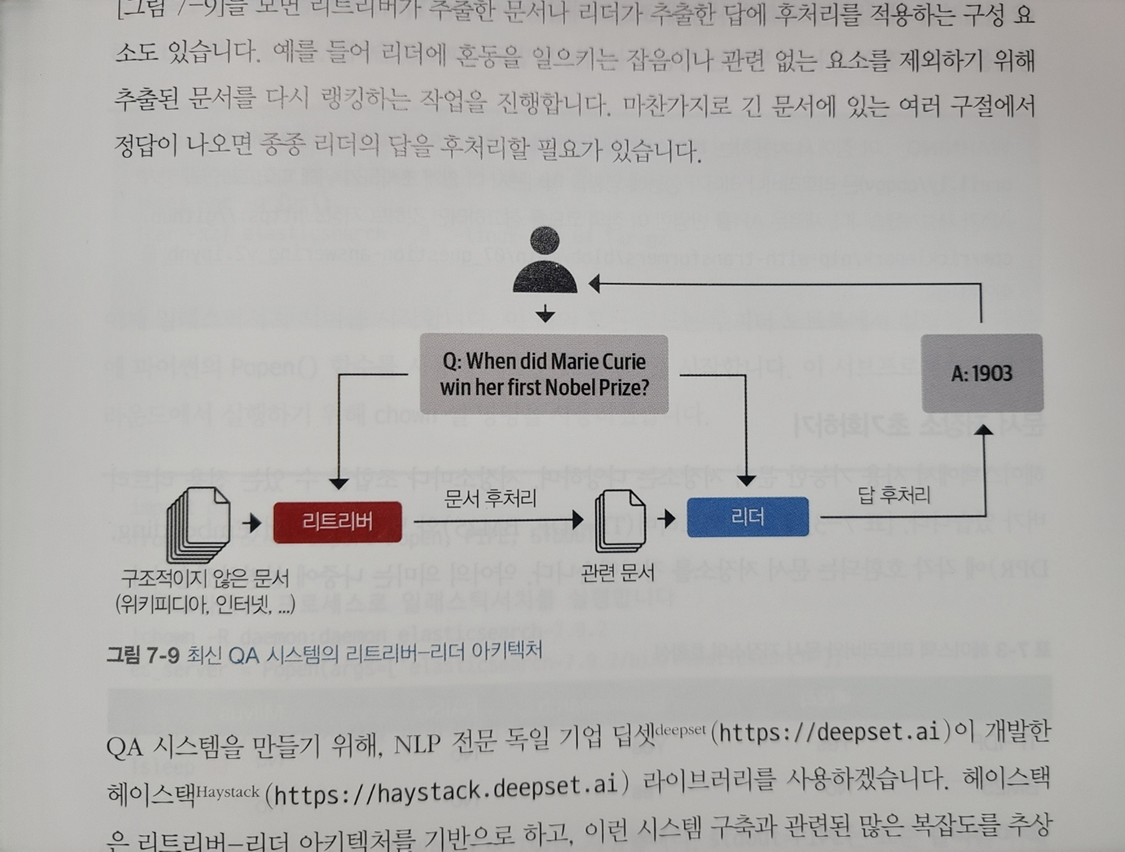

CH7. 질문 답변

- 리뷰 기반 QA 시스템 구축하기

- QA 파이프라인 개선하기

- 추출적 QA를 넘어서

- 결론

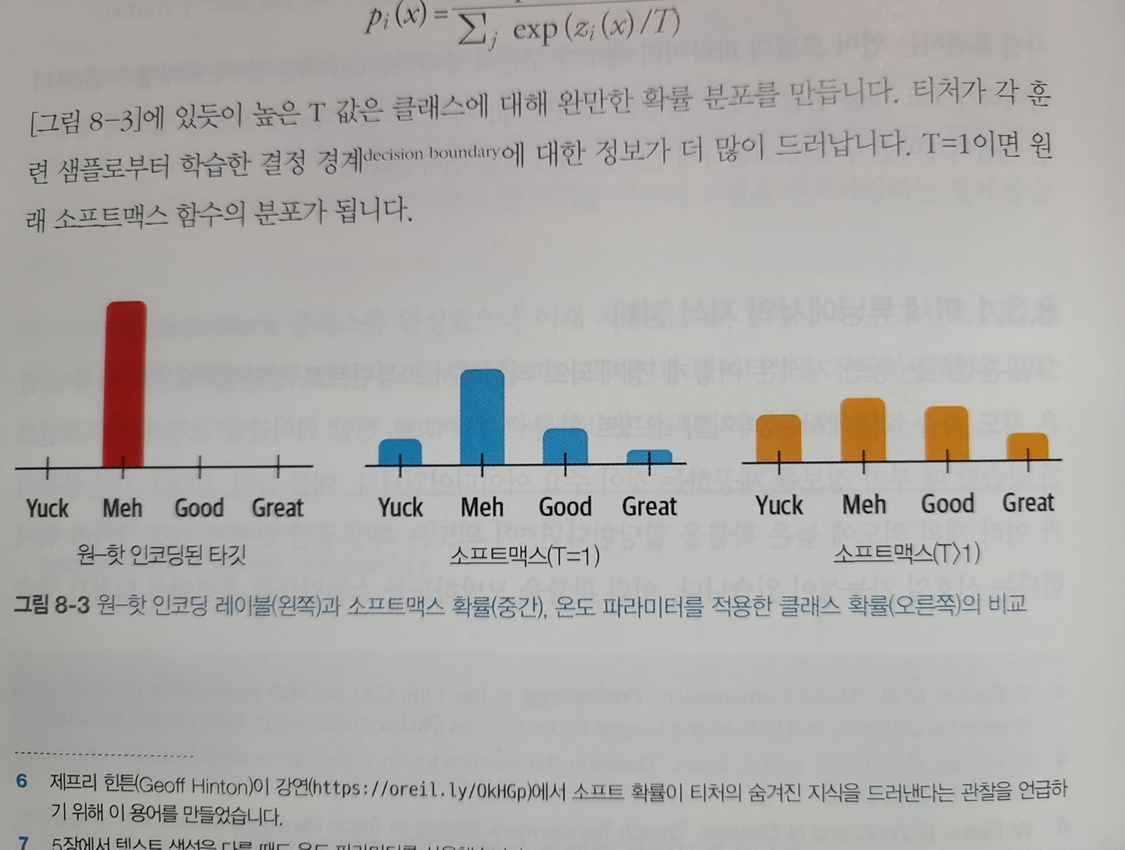

CH8. 효율적인 트랜스포머 구축

- 의도 탐지 예제

- 벤치마크 클래스 만들기

- 지식 정제로 모델 크기 줄이기

- 양자화로 모델 속도 높이기

- 양자화된 모델의 벤치마크 수행하기

- ONNX와 ONNX 런타임으로 추론 최적화하기

- 가중치 가지치기로 희소한 모델 만들기

- 결론

CH9. 레이블 부족 문제 다루기

- 깃허브 이슈 태거 만들기

- 나이브 베이즈 모델 만들기

- 레이블링된 데이터가 없는 경우

- 레이블링된 데이터가 적은 경우

- 레이블링되지 않은 데이터 활용하기

- 결론

CH10. 대규모 데이터셋 수집하기

- 대규모 데이터셋 수집하기

- 토크나이저 구축하기

- 밑바닥부터 모델을 훈련하기

- 결과 및 분석

- 결론

CH11. 향후 방향

- 트랜스포머 확장

- 텍스트를 넘어서

- 멀티모달 트랜스포머

- 다음 목적지는?

책을 읽고

▶ 주관적인 평점 : 4.9점 / 5.0점

처음 도서를 훑어보았을 때, 입문자 분들에게는 난이도가 있을 것이라 생각을 하였습니다. 하지만, 책을 읽으면서 생각했던 대로 난이도가 있었으나 입문자 분들도 조금 더 노력하신다면 충분히 이해할 수 있을 정도의 설명이 제공되고 있었습니다.

또한, 다뤄지는 내용이 체계적이고 실용적인 부분들이 많아 어렵더라도 이 책으로 공부하시는게 좋다고 추천해 드릴 수 있을 정도였으며,

관련 링크

[1] 한빛출판네트워크 - 트랜스포머를 활용한 자연어 처리

[2] 예제 소스 - github